Shiru Cafe es una marca de cafeterías que se ha especializado en ofrecer café gratis a los estudiantes que les proporcionen datos que resulten de interés para las empresas patrocinadoras. Por lo tanto, lo que ha hecho esta empresa es trasladar a los negocios del mundo real el modelo de negocio más exitoso hasta la fecha en Internet: ofrecer un servicio de forma gratuita a los usuarios, al tiempo que éstos proporcionan a la empresa información que puede monetizar a través de publicidad que compran otras empresas.

La historia de Shiru y su café patrocinado bien podría servir como un punto de inflexión respecto a cómo se gestionan los negocios basados en los datos. Realmente resulta curioso que usemos como ejemplo una empresa offline para explicar la idea de que estamos llegando a un punto en el que la gente ya no quiera ceder sus datos a las empresas digitales que les ofrecen productos o servicios de forma gratuita.

«El mayor problema político, legal y filosófico de nuestra época es cómo regular la propiedad de los datos. En el pasado, delimitar la propiedad de la tierra fue fácil: se ponía una valla y se escribía en un papel el nombre del dueño. Cuando surgió la industria moderna, hubo que regular la propiedad de las máquinas. Y se consiguió. Pero, ¿los datos?. Están en todas partes y en ninguna. Puedo tener una copia de mi historial médico, pero eso no significa que yo sea el propietario de esos datos, porque puede haber millones de copias. Necesitamos un sistema diferente. ¿Cuál?. No lo sé. Otra pregunta clave es «cómo conseguir una mayor cooperación internacional». Yuval Noah Harari

El modelo de negocio de los datos en la actualidad

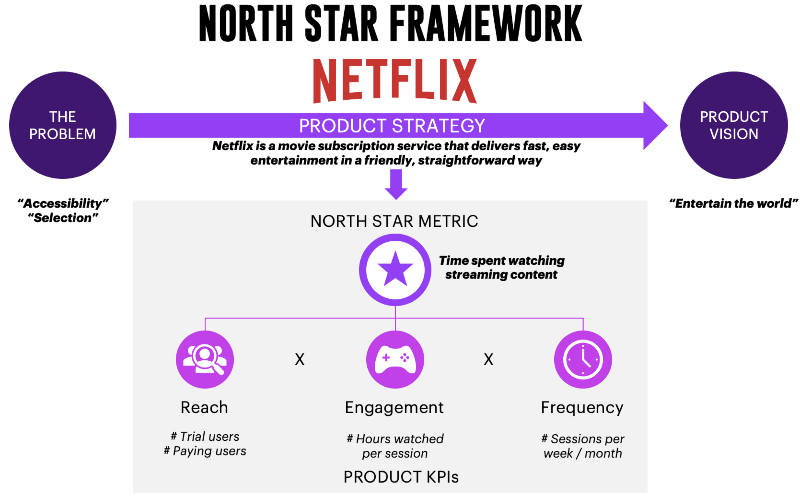

Las 5 empresas más valiosas del mundo tienen modelos de negocio digitales, no exclusivamente basados en los datos, pero sí que son todas empresas de software y hardware que desarrollan una gran actividad en la generación y procesamiento de información en forma de datos, especialmente Google y Facebook, aunque cada vez más también Microsoft con su apuesta por el Cloud y Amazon con su apuesta por los asistentes virtuales basados en Inteligencia Artificial.

Si pensamos en cómo rentabilizan su actividad las empresas denominadas GAFA (Google, Apple, Facebook y Amazon), entendemos por qué se dice que el nuevo oro son los datos y que los datos son el combustible que hace que se mueva la maquinaria de una nueva revolución industrial, la 4.0

Más allá de estas analogías lo que está claro es que en los últimos 20 años hemos visto surgir uno de los modelos de negocio más rentable de la historia: las plataformas digitales que rentabilizan sus audiencias a través de la publicidad.

Google con su publicidad contextual inventó un modelo de negocio basado en saber lo que hacemos cuando buscamos información en Internet, cuando navegamos, cuando nos comunicamos por correo electrónico, cuando trabajamos con herramientas de ofimática online, cuando viajamos ayudados por el GPS, … así hasta el punto de que una de las últimas grandes apuestas de la empresa en lo que a innovación se refiere pasa por entrar en el sector del transporte a través de la conducción autónoma, porque la empresa quiere acompañarnos allá donde queramos ir para estar de manera omnipresente con nosotros y poder mostrarnos en cualquier momento sus anuncios relacionados con el contexto.

Facebook con su publicidad segmentada que le ha ayudado a generar un enorme negocio mostrando anuncios basados en lo que dice la gente que le gusta, piensa, interesa, comenta, … en esta red social y sus app asociadas (Whatsapp e Instagram) que aglutinan a miles de millones de personas, que están constantemente compartiendo información desde sus smartphones. Una información que resulta ideal para cruzar con publicidad de todo tipo de empresas que están deseosas de ofrecer nuevos productos o servicios a los usuarios en estas redes sociales.

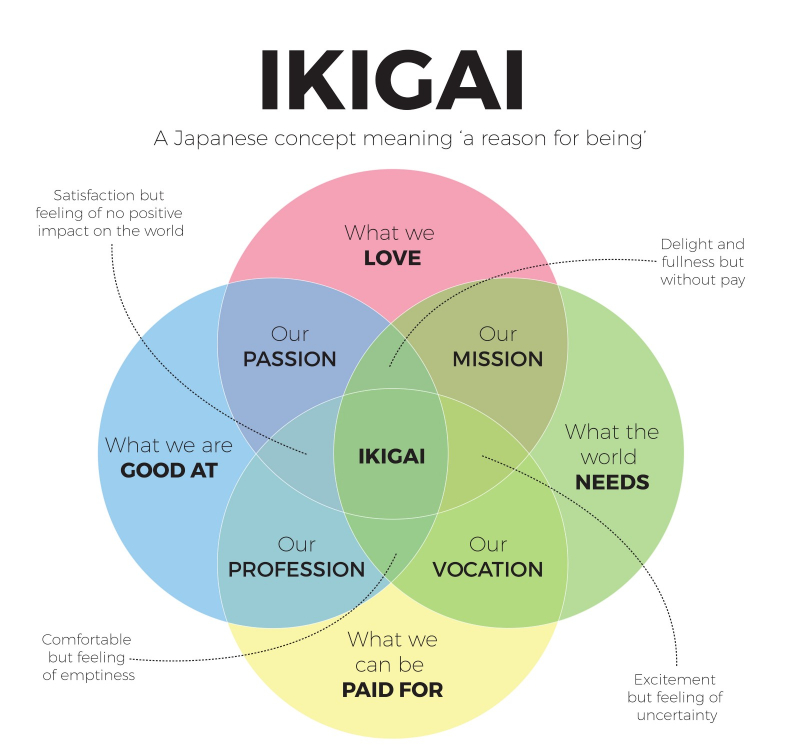

Nota sobre la imagen: cuando una startup decide desarrollar un nuevo modelo de negocio una de las primeras cosas que debería hacer es el Mapa de Empatía como una forma de ponerse en la piel del que será su cliente e intentar entender cuáles son sus necesidades reales para las cuales posteriormente se podrá construir una propuesta de valor en la que se basará el negocio de la compañía. En el caso de empresas como Google, Facebook y Amazon, lo que han sido capaces es de generar ecosistemas de los que se destila perfectamente lo que los usuarios necesitan; en el caso de Google, por su gran capacidad de saber lo que el usuario está haciendo; en el caso de Facebook, por lo que dicen y piensan las personas; y en el caso de Amazon, por la posibilidad de adelantarse a las necesidades de sus clientes en relación con las cosas que están interesados en comprar.

Si lo pensamos bien, lo que estas grandes empresas han logrado a través de la innovación en sus modelos de negocio es generar una economía basada en ofrecer a otras empresas nuevas formas de anunciarse e interactuar con sus clientes. Google, como gran catalizador de la web basada en contenido, donde las empresas puedan darse a conocer a través de la información que generan basada en el conocimiento del sector en el que trabajan. Facebook, por medio de las interacciones que los usuarios pueden realizar con las marcas, aquellas que admiran o las que necesitan en su día a día. Amazon, ofreciendo un marketplace en el que cualquier empresa tiene a su disposición a millones de clientes dispuestos a darle trabajo a su tarjeta de crédito.

Por lo tanto, en el lado positivo de la balanza, nos encontramos con la capacidad de estas tres empresas de crear nuevos mercados y potenciar la economía, como por ejemplo la de las pequeñas empresas que antes tenían muy limitadas las opciones para darse a conocer a nivel global, debido a los altos costes de la publicidad en otros medios como la televisión o la prensa y la baja capacidad de «convertir y medir» que ofrecían estos canales.

Pero en el lado negativo nos encontramos todo lo relacionado con los problemas de la privacidad y el control que ejercen estas empresas sobre lo que se sabe de nosotros, algo que en muchas ocasiones puede ser tan importante como aquello que somos. Sobradamente conocidos a este respecto son todos los problemas que pueden suponer para la gente las cosas que publican en las redes sociales, en lo que se refiere a su reputación personal, que tan valiosa resulta a la hora, por ejemplo, de conseguir un empleo, o en aspectos mucho más críticos como pueden ser los relacionados con la seguridad.

Lo que cada vez todos tenemos más claro es que usar los servicios gratuitos que encontramos en Internet tiene un coste que no se paga con dinero, sino con datos. Y, para usarlos, hace falta mucho más que saber manejar aplicaciones online, también hay que ser inteligentes a la hora de decidir qué publicamos en ellas y qué dejamos al resguardo de nuestra privacidad. A este respecto no vamos a profundizar mucho aquí, pero no por ello queremos restarle importancia, de forma que lo que sí que os recomendamos es leer el libro «Datanomics» escrito por Paloma Llaneza o escuchar este podcast que sirve como un buen resumen del libro, en lo que se refiere a la parte de peligros de hacer un mal uso de los datos.

A continuación puedes leer un pequeño extracto del libro que sirve como un buen reflejo de lo interesante que puede resultar su lectura para entender bien lo que implica todo este tema de los datos en el mundo digital.

«Los datos están en nosotros. Somos productores de datos. Una mezcla de percepción equivocada y conocimiento de nuestros sesgos y adicciones nos ha convertido en productores intensivos de datos, recursos necesarios para que siga funcionando una maquinaria de servicios por los que no queremos pagar con dinero. Los datos cuentan nuestro pasado con una precisión nunca vista hasta ahora, y son los posos sobre los que se lee nuestro futuro con los algoritmos que, en muchos casos, lo convierten en una profecía autocumplida. Frente a negocios extractivos de este nuevo petróleo, se alzan cuestiones sobre quién ha de recibir el dividendo de los beneficios que nuestros dobles, nuestros doppelgänger digitales, generan a las empresas que los usan. Y entre tanto ciberoptimismo, el control de los datos se usa como herramienta de control social en un mundo en el que todo lo que se almacena en un sistema informático es susceptible de ser robado. La cuestión, al final, es que ceder nuestros datos excede de la elección individual, cuestionable, como veremos, al afectar a la convivencia y a los fundamentos de las reglas sociales que nos hemos dado para convivir.» Paloma Llaneza

Los bloqueadores de publicidad como indicio de que algo puede estar cambiando

Si lees el libro «Datanomics» o permaneces atento a las noticias que se publican al respecto de los problemas de gestión de los datos personales de sus usuarios que ha tenido Facebook en los últimos años, tendrás claro que algo tiene que cambiar en el futuro si queremos seguir construyendo valor para las personas a través de la tecnología y los negocios digitales. Algo que ha sido así durante mucho tiempo por las grandes ventajas que nos ha aportado Internet y la movilidad, pero que parece estar llegando a un punto de agotamiento donde los inconvenientes empiezan a destacar sobre las ventajas que recibimos. Aunque, por otro lado, pueda resultar contradictorio que, ante esa gran crisis de la gestión de la privacidad que se ha producido en Facebook (que la ha llevado a recibir una multa de 5.000 millones de dólares por parte del Gobierno de los Estados Unidos) ésto no se haya visto reflejado en las cifras de actividad de sus usuarios, en el crecimiento del número de éstos y en el crecimiento de su negocio.

Frente a esta contradicción, tenemos que guiarnos por el sentido común y pensar como los expertos en materia de privacidad y las instituciones que se preocupan por ello, que consideran que ha llegado el momento de pasar a la acción en lo relativo a mejorar la forma en la que se gestiona la información de las personas en Internet. Personas que, de alguna manera, también empiezan a preocuparse por ello, como muestra el incremento en el uso de los bloqueadores de publicidad del que habla el artículo «Llega el fin de la publicidad en Internet. Los usuarios han ganado la batalla» escrito por Doc Searls, uno de los autores del conocido y recomendado Manifiesto Cluetrain.

«Yo creo que el principal motivo por el que la gente rechaza la publicidad se puede resumir en una palabra: rastreo. Durante la última década, ha crecido el uso de la tecnología que acechan bajo la superficie de los anuncios en línea por parte de las empresas para captar tantos datos sobre nosotros como sea posible. Los anunciantes no tienen que construir esta capacidad por sí mismos: pueden depender de redes de distribución de publicidad que aseguran mostrar anuncios relevantes a los usuarios sin importar qué página web visiten. Shoshana Zuboff, de la Escuela de Negocios de la Universidad de Harvard (EEUU), lo llama el capitalismo de la vigilancia.» Doc Searls

Otro indicio del cambio que se puede estar produciendo en todo lo relativo a cómo las grandes empresas tecnológicas gestionan nuestros datos, es que, cada vez más, la opinión pública reacciona con mayor rapidez y contundencia frente a los posibles abusos que realizan estas empresas; por ejemplo, en los últimos meses estamos viendo cómo las empresas se ven obligadas a modificar las estrategias de gestión de los datos que se generan en los dispositivos de moda, los altavoces inteligentes tipo Alexa.

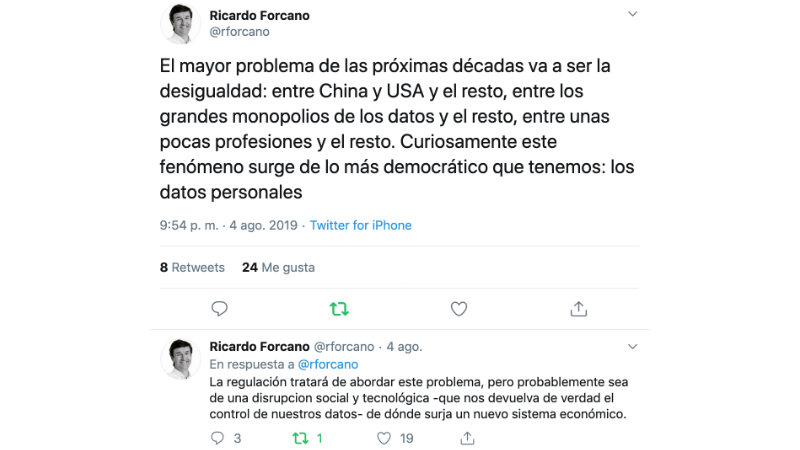

Reacciones de la opinión pública que también están haciendo reaccionar a los políticos que ven cómo algunas empresas tienen demasiado poder y se exceden en la forma en la que lo utilizan. Una muestra de esta reacción pueden ser, por ejemplo, las palabras:

«Los datos son la materia prima de la economía del siglo XXI. Ponerle precio a los datos, sobre todo los de los consumidores, es desde mi punto de vista un asunto esencial para garantizar un mundo justo». Angela Merkel

La postura de Apple como ejemplo de que se pueden hacer las cosas de otra forma

Lo que podemos preguntarnos en este punto es si hay alternativa al modelo de negocio que se ha desarrollado en Internet en los últimos 20 años. Fijarnos en la postura de Apple al respecto puede ser una buena opción para continuar con esta reflexión:

«Hay una economía sumergida de datos personales, y está descontrolada. Es hora de defender el derecho a la privacidad. El tuyo, el mío y el de todos nosotros. Los consumidores no deberían tener que tolerar otro año de compañías que acopian de manera irresponsable amplísimos perfiles de usuario, de violaciones de datos que parecen estar fuera de control, y de pérdida de la capacidad de controlar nuestras propias vidas digitales. Este problema se puede solucionar. No es aún demasiado grande, ni demasiado desafiante y tampoco es demasiado tarde. La innovación, las grandes ideas y las excelentes capacidades técnicas pueden ir de la mano de la privacidad del usuario. Y deben hacerlo, porque desplegar el potencial de la tecnología depende de ello». Tim Cook

Unas palabras que deberían servir para concienciar a toda la industria tecnológica al respecto de la necesidad de afrontar cambios en la forma en la que se gestiona este tema de los datos.

Aunque en la propia empresa Apple también deben aplicar estas ideas con la máxima rigurosidad, sobre todo después de la noticia que expuso que la empresa contaba con una iniciativa en la que sus trabajadores revisaban las conversaciones que mantenían las personas con Siri para mejorar el servicio, lo cual puede ser una violación de su privacidad.

Esta situación refleja lo realmente complicado que es el tema, algo que a su vez debe hacernos pensar en que existe una gran oportunidad para aquellos que decidan solucionarlo.

«Los mayores problemas del mundo son también los mayores mercados del mundo». Peter Diamandis

Telefónica ha tenido una buena idea pero no parece que esté siendo capaz de materializarla

En 2017 Telefónica nos sorprendió con una noticia bastante llamativa por lo innovadora de la idea que quería transmitir. Hacía tiempo que desde la Telco española se hablaba de que, de toda la información que circulaba por las redes, el mayor beneficio se lo llevaban empresas como Google y Facebook, pero ellos que ponían la infraestructura debían jugar un papel más relevante.

La forma de materializar esta idea fue promover un modelo llamado Cuarta Plataforma en la que se defendía el siguiente argumento: «queremos ceder a lo clientes todo el control sobre los datos que generan utilizando los servicios de la compañía (su localización cada vez que se conecta o llama, las webs a las que entra con su servicio de datos online, qué series o películas ve y cuántas veces en Movistar Plus…). Para ello transformaremos la información en conocimiento, y lo compartiremos con los clientes para que lo utilicen para enriquecer su vida».

Una idea, la de la cuarta plataforma, que un año después evolucionó para integrarse con su estrategia de utilización de la Inteligencia Artificial y asistentes virtuales a la que han llamado Aura:

«Aura redefine la interacción entre Telefónica y sus clientes. Ofrecerá seguridad y simplicidad en las formas, transparencia y control sobre sus datos personales, facilitándoles además el descubrimiento de nuevos usos para ponerlos en valor y todo ello a través de múltiples canales y dispositivos. Todo esto es posible gracias al flujo de dichos datos que hasta ahora generaban de forma ininterrumpida, aunque fragmentada, las redes y otros activos físicos de la compañía (1ª plataforma y el activo fundamental sobre el que se apoyan el resto), sus sistemas unificados de IT (2ª plataforma), así como los productos y servicios que ofrece a sus clientes (3ª plataforma). Este nuevo modelo de compañía basado en plataformas inteligentes supondrá un gran salto cualitativo en el modelo de relación de los clientes con la compañía».

Como decimos la idea de dar el poder a los clientes sobre los datos que generan resulta muy interesante pero nos tememos que no va a ser sencillo encontrar una forma de convertirlo en una realidad, principalmente porque los usuarios cuando piensan en empresas como Google, Facebook o Amazon cuando interactúan con Internet, pero no en la empresa que les proporciona los cables o las ondas a través de las cuales utilizan esos servicios.

La extraña estrategia de Facebook que parece ir contra su propio modelo de negocio

¿Podría Facebook pasar de ser la empresa más odiada por los defensores de la privacidad, a convertirse en la promotora de un cambio radical en el modelo de negocio basado en la gestión de los datos digitales de las personas? Quizás algo parecido a lo ocurrido con Microsoft que ha pasado de ser el mayor enemigo del software libre para convertirse en su promotor con iniciativas como la compra de Github.

Parece bastante improbable, pero algunas noticias recientes nos hacen pensar en que puede haber una pequeña opción.

- El lanzamiento de la aplicación Study from Facebook a través de la cual la empresa gestionará un sistema de incentivos económicos para aquellas personas que le ayuden a mejorar su servicio a través de proporcionarle información específica que la empresa necesita.

- La publicación de la herramienta que permite a los usuarios conocer la información que los sitios web comparten con Facebook y borrar esta información si así lo considera el usuario.

- Y la noticia más relevante de la empresa en los últimos años con el lanzamiento de su criptomoneda Libra, la cual ha llegado rodeada de polémica por vincularse con la falta de prejuicios de la empresa al respecto de cómo gestiona nuestros datos, pero que por otro lado podría pensarse en que puede ser un cambio de tendencia a través del cual se ha decidido tener una mayor consideración hacia los usuarios que formarían parte de un ecosistema en el que no se maneja únicamente información sino también una economía de la cual pueden salir beneficiados.

Destacar aquí en este tema de Libra, la gran acogida que ha logrado por parte de importantísimas empresas en el ámbito financiero y digital que se han convertido en socios del proyecto.

¿Podría la economía evolucionar de un modelo basado en el dinero a uno nuevo basado en los datos?

Cuando hace miles de años la humanidad evolucionó de una economía basada en el trueque a una basada en el dinero o monedas, el trueque no desapareció. De hecho, como la población y la actividad económica han crecido muchísimo, el trueque se usa actualmente en una cantidad mucho mayor de lo que se usaba en la prehistoria. Del mismo modo cuando se empezaron a usar los pagos electrónicos, no dejó de usarse el dinero en metálico, aunque ahora se mueva mucho más dinero de manera electrónica, tanto en lo que se refiere a negocios entre empresas como por parte de los particulares. De esta forma podría ocurrir que, en un futuro, el dinero, en su formato actual de monedas creadas por los países para representar el valor de su economía y poder realizar transacciones para pagar por aquellas cosas que tienen valor para nosotros, deje de tener la predominancia que ahora tiene para evolucionar a un nuevo modelo en el que los datos tomen el protagonismo de la economía.

En una economía basada en los datos no sería necesario convertir el valor que estos representan en dinero, sino que se podría realizar un intercambio comercial directo con los propios datos. Pensemos por ejemplo en la compra de Motorola por parte de Google en 2011 por un valor de 12.500 millones, con el objetivo de hacerse con las patentes del fabricante de móviles. Si consideramos una patente como un dato y pensamos también que una acción de Google es un dato, la transacción podría haberse realizado directamente como un intercambio de patentes por acciones, sin la necesidad de reflejar en ningún momento el valor a través del dinero. Seguro que los accionistas de Motorola habrían estado muy satisfechos con la operación, considerando que las acciones de Google han multiplicado por cuatro su valor desde 2011.

Una de las claves que pueden sostener el argumento de que la economía podría evolucionar a un modelo basado en los datos, en lugar del dinero, la encontramos al fijarnos en cómo funcionan las grandes empresas en cuanto a la forma de representar el beneficio que reciben sus accionistas a través de las acciones de la empresa. Pensemos, por ejemplo, en que las personas más ricas del mundo no lo son por tener mucho dinero acumulado en los bancos o en propiedades inmobiliarias, sino que las grandes fortunas se ven siempre representadas por la posesión de acciones de empresas, que además, curiosamente, en los últimos años, son de empresas que basan sus modelos de negocio en los datos: Google, Apple, Facebook y Amazon.

En todo caso, está claro que este escenario en el que la economía evolucionase a un nuevo modelo de negocio basado en los datos, es algo improbable en el corto plazo, entre otras cosas por las siguientes razones:

- Las grandes empresas digitales como Google y Facebook viven muy bien con su modelo de negocio actual basado en la publicidad contextual y segmentada, por lo tanto, aunque reciban grandes multas por no gestionar adecuadamente los datos de sus usuarios, pueden seguir ganando muchísimo dinero con su modelo actual. Pensemos, además, en la inercia de negocio que han logrado estas empresas, lo cual les permite invertir cantidades ingentes de dinero en lo que pueden ser grandes negocios de futuro, como la Inteligencia Artificial en el caso de Google y la Realidad Virtual en el caso de Facebook. Esa capacidad de evolucionar y adaptarse, manteniendo un modelo de negocio basado en los datos hace que estas empresas puedan seguir muchos años siendo líderes de la economía sin cambiar sustancialmente su manera de funcionar.

- El valor de los datos de una única persona al azar es pequeño, porque donde está el gran valor es en agregar los datos de mucha gente para poder obtener conclusiones de su análisis. Esto es así en este momento ya que las empresas que utilizan los datos para definir sus estrategias, por ejemplo, para diseñar nuevos productos o sus ofertas comerciales, lo hacen considerando tendencias en los hábitos de consumo y no circunstancias concretas de una persona a nivel particular.

- En cuanto a las personas, al menos por lo que dicen muchos estudios, la generación llamada millenial no se preocupa mucho por su privacidad. Es más, le encanta la visibilidad que le proporcionan las redes sociales y le preocupa poco qué ocurrirá con sus datos. Por lo tanto, lo que vamos a tener que descubrir con el tiempo es qué resulta más valioso para las personas, la visibilidad que les aporta exponerse sin control en las redes sociales o cuidar su intimidad por las consecuencias que esto pueda tener para ellas en el futuro.

Y, por otro lado también podemos pensar en las razones que pueden ayudar a que prospere un nuevo sistema de gestión de los datos donde las personas que los generan tengan el control y obtengan el mayor beneficio:

- Presión regulatoria de los gobiernos en materia de privacidad. Una tendencia imparable a la vista de nuevas leyes, como el famoso RGPD.

- Penalizaciones a las empresas por problemas con la privacidad de los datos, porque no solo se trata de cumplir la ley, sino que además, en algunos casos, las multas pueden poner en peligro la viabilidad de las empresas.

- Cambio en los hábitos e intereses de los usuarios al respecto de su privacidad. Un tema con muchas luces y sombras del que parece que solo conoceremos la solución con el paso del tiempo.

- Aumento del uso de los bloqueadores de anuncios, lo cual ya hemos comentado en este artículo como un indicio del posible cambio de tendencia al respecto del interés de las personas por proteger su privacidad.

Ventajas de este nuevo modelo de negocio de los datos para las empresas:

- Los datos están segmentados y contextualizados ya que han sido obtenidos de manera premeditada por la empresa a través de una campaña de captación de datos específica, por lo tanto se evita uno de los grandes problemas del Big Data que es disponer de datos de calidad debidamente estructurados.

- Los datos son sólo de aquellas personas que realmente coinciden con los intereses de la empresas, de forma que se soluciona otro de los problemas del Big Data que es tener que manejar grandes volúmenes de información de la cual una parte muy importante realmente no tiene valor para la empresa.

Ventaja del nuevo modelo de negocio de los datos para las personas:

- Beneficio económico al recibir una remuneración por parte de aquellas empresas que quieran acceder a sus datos y con las que se puede establecer una relación comercial basada en la confianza.

- Recibir publicidad u ofertas sólo de las empresas en las que realmente se está interesado, considerando que este nuevo modelo de negocio no persigue acabar con la publicidad, sino mejorarla.

Startups con ganas de cambiar el status quo de los negocios digitales basados en los datos

“Nunca cambiarás las cosas luchando contra la realidad existente. Para cambiar algo, construye un nuevo modelo que haga que el modelo actual sea obsoleto.” Buckminster Fuller

Esta frase del famoso arquitecto Buckminster Fuller podría servir como una especie de premonición de lo que debería ocurrir ante esta posible revolución que supondría un cambio en el sistema económico en el que los datos cada vez tomen una mayor relevancia sobre el dinero.

Porque cuando se habla de construir nuevos modelos que dejen obsoletos a los anteriores, la historia nos muestra como esto no suele suceder por la acción de empresas ya existentes, a las que se suele denominar como incumbentes, sino que esa innovación suele llegar desde las startups. De esta forma, en el momento en el que empezamos a investigar sobre propuestas que buscan cambiar el modelo de negocio de los datos en Internet, lo que nos encontramos es la iniciativa de varias startups que quieren usar Blockchain para aportar soluciones a este problema.

En este contexto una de las aportaciones que puede realizar Blockchain para el futuro es el desarrollo de la Internet del Valor, donde aquellas cosas que tienen valor, como son los datos, la identidad, la reputación, … pueden llegar a ser gestionados de forma digital al igual que ahora gestionamos el dinero. Sobre este argumento están empezando a surgir algunas startups que buscan ayudarnos a los usuarios a tomar el control de nuestros datos y obtener un beneficio económico por ello.

Os presentamos a continuación algunas de las más interesantes que hemos encontrado:

Wibson es una startup con sede en San Francisco, que cuenta con el apoyo financiero de Telefónica, DGG Capital y Kenetic Capital, y se presenta con el siguiente argumento: tus datos personales son vendidos por sitios webs y apps que usas todos los días. Wibson te da el control para que tú mismo los vendas y elijas a quién vendérselos. Y además, te hace partícipe de las ganancias. Para ello están construyendo un mercado de datos de consumo basado en Blockchain y se han asociado con Telefónica para probar una capacidad de verificación de datos que valida la autenticidad de los datos en su sistema, permitiendo a las personas vender de manera segura y anónima información privada de sus dispositivos a anunciantes y negocios en un entorno confiable.

GeoDB es una startup española que está creando un marketplace para democratizar la compraventa de datos, donde pagará a las personas por el uso que las empresas hagan de sus datos. Para ello están desarrollando un protocolo descentralizado que funcionará como un mercado de datos, donde estarán presentes tanto los usuarios que generan la información como las empresas que la necesitan. Para conseguirlo la empresa ha realizado una ronda de inversión de 1,2 millones de euros en la que han participado los fondos Next Chance Invest, Levo Capital y PadeInvest.

La posible aportación de la economía colaborativa a este cambio en el modelo de negocio digital

Supongamos que con el auge de la economía colaborativa o de la Gig Economy, potenciado por la crisis económica vivida durante varios años posteriores a 2008, vamos a dirigirnos a un nuevo modelo económico en el que la gente no tiene cosas en propiedad sino que simplemente paga por su uso cada vez que necesita algo ¿Se seguirán realizando estos pagos con dinero convencional o se desarrollará una economía más parecida al trueque que al sistema monetario? ¿Tendrán un papel relevante en este escenario las criptomonedas? Si estas plataformas de la Gig Economy trabajan con grandes volúmenes de datos proporcionados por sus usuarios, ¿serán capaces de generar alternativas de negocio basadas en el uso de esos datos?

Y ya que hemos empezado a hacernos preguntas, para terminar con este artículo, os dejamos una serie de ideas que se nos quedan en el tintero, a las que quizás podamos ir respondiendo aquí más adelante, apoyados por el debate que se genere gracias a vuestros comentarios:

- ¿Qué podemos aprender de las economías virtuales que se desarrollan en los videojuegos y los mundos virtuales al respecto de una posible economía basada en los datos?

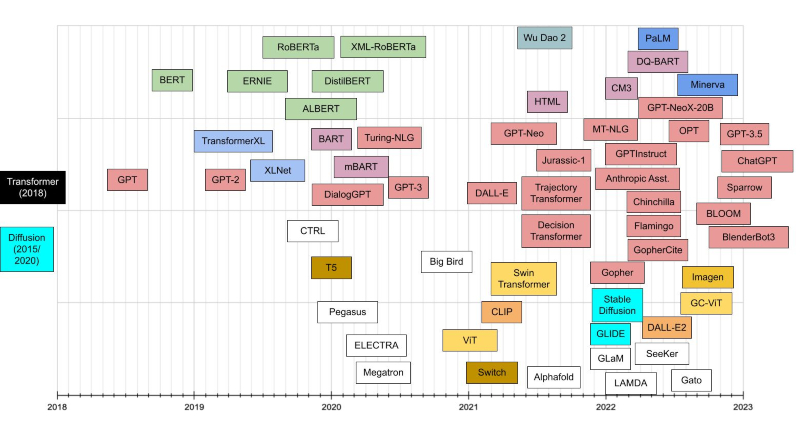

- Los datos son el alimento necesario para que aprenda la Inteligencia Artificial, por lo tanto las empresas que se dedican a desarrollar esta tecnología cada vez van a necesitar más datos.

- La llegada del 5G va a acelerar la forma en la que generamos y gestionamos los datos.

- ¿Son los influencers los primeros que han comenzado a monetizar sus datos?

- La proliferación de dispositivos como los wearables y el comienzo del uso de la biometría va a aumentar significativamente la cantidad y calidad de los datos que generamos en nuestro día a día.

- Los datos son mucho más que lo que generamos cuando navegamos por Internet, hay datos enormemente más valiosos, como los que se encuentran en nuestro código genético y sobre esto también se puede generar una economía muy importante, en la que intervienen las empresas que trabajan en el ámbito de la medicina personalizada.

- ¿Cómo puede cambiar todo este escenario con la llegada de las comunicaciones cuánticas?

Etiquetas: Big Data, datos, facebook, Google